J’ai volontairement omis de vous parler d’entropie dans mon dernier billet sur les températures absolues négatives, car cette notion est tellement fondamentale qu’elle méritait un billet à part entière. Inventé au siècle des machines à vapeur, ce concept a été historiquement construit à partir de considérations de chaleur, de pistons, de moteurs etc. Mais à l’aube de la révolution informatique du XXe siècle, l’entropie a été entièrement redéfinie à partir de la notion d’information et d’incertitude: une belle illustration de l’influence de la société sur la méthode scientifique. Les deux approches sont équivalentes, mais étant moyennement sensible au charme des pistons, je préfère vous présenter la seconde, plus intuitive et pus générale.

Une histoire de dés

Le « Can’t Stop » est un jeu de société très simple mais très sympa. C’est une sorte de jeu de l’oie où les pions sont des grimpeurs escaladant des colonnes numérotées de 2 à 12. Le but du jeu est de choisir une colonne pour son grimper et qu’il soit le premier à arriver en haut de sa colonne. Pour monter d’un cran sur la colonne 5, il faut faire exactement 5 en lançant deux dés (3 et 2 par exemple ou 4 et 1). Les colonnes sont de différentes longueurs, les plus grandes au centre et les plus petites sur les bords.

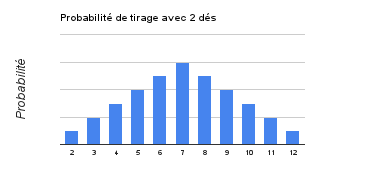

Quand on commence à jouer, on se dit qu’il est plus facile d’arriver rapidement au sommet de la colonne 2 (seulement 3 cases à grimper) que de la colonne 7 (13 cases). Mais dès qu’on pratique un peu, on se rend vite compte que c’est plutôt l’inverse. Car même s’il y a 4 fois moins de cases à grimper dans la colonne 2, il y a 6 fois moins de chance de tirer un 2 (une seule combinaison: {1,1}) qu’un 7 (6 combinaisons: {1,6},{2,5},{3,4}{4,3}{5,2}{6,1}).

Quand on commence à jouer, on se dit qu’il est plus facile d’arriver rapidement au sommet de la colonne 2 (seulement 3 cases à grimper) que de la colonne 7 (13 cases). Mais dès qu’on pratique un peu, on se rend vite compte que c’est plutôt l’inverse. Car même s’il y a 4 fois moins de cases à grimper dans la colonne 2, il y a 6 fois moins de chance de tirer un 2 (une seule combinaison: {1,1}) qu’un 7 (6 combinaisons: {1,6},{2,5},{3,4}{4,3}{5,2}{6,1}).

Pour que les chances soient équilibrées il aurait fallu que la taille des colonnes soit proportionnelle à la probabilité de tirer le numéro de la colonne ou ce qui revient au même, au nombre de combinaisons. Le tapis de jeu serait beaucoup plus étalé:

L’entropie et le deuxième principe

Ce qu’on appelle « l’entropie » de chaque score correspond à la taille de ces colonnes: elle mesure notre ignorance sur l’état exact d’un système, l’incertitude sur l’arrangement exact qui permet d’obtenir ce score. Elle est minimale s’il n’y a pas d’ambigüité sur le tirage de chaque dé (par exemple pour le score 2, chaque dé est forcément 1) et maximale pour le score moyen de 7 qui autorise un plus grand nombre de combinaisons gagnantes. L’échelle des probabilités est donc une mesure possible de l’entropie. Sans le savoir on a donc déjà fait le diagramme d’entropie de chaque score. Trop fort!

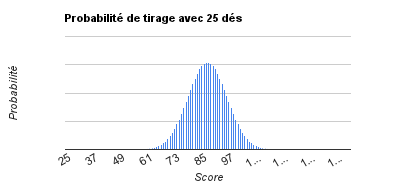

La thermodynamique postule que l’état d’équilibre d’un système isolé est celui dont l’entropie est maximale. C’est le deuxième principe -le premier étant le postulat de conservation d’énergie. Il a l’air un peu compliqué dit comme ça, mais on va voir que c’est un effet de statistiques très simple. Imaginez un jeu de Can’t Stop avec non plus 2 dés mais 25 dés. Voici à quoi ressemblerait le nouveau diagramme d’entropie (j’ai trouvé les statistiques sur ce site):

Bien sûr la palette des scores est plus large (elle va de 25 à 150) mais les probabilités sont beaucoup plus resserrées autour du score moyen. On n’a pratiquement aucune chance de tirer un score plus faible que 60 ou plus grand que 100. Les probabilités des scores moyens (proches de 25 x 3.5 = 88) dominent toutes les autres. Si maintenant on jouait au Can’t Stop avec 100000 dés, voici à quoi ressemblerait notre diagramme d’entropie pour les différents scores:

Avec 100 000 dés on est sûr de tirer un score très proche de 3.5 fois le nombre de dés, grâce à la loi des grands nombres. Mais souvenez-vous: la probabilité d’un score mesure d’une certaine manière son entropie. Notre système s’est calé sur son état d’entropie maximale, comme le prévoit le deuxième principe de thermodynamique. C’est tout bête!

L’irréversible tendance au désordre

Source ici

Vous avez sans doute entendu une version plus anthropocentrique du deuxième principe, du type: « tout système bien ordonné tend à se désorganiser si on laisse les choses se faire ». Dit comme ça, ce n’est pas évident de voir le rapport avec ce qui précède. Les deux formulations sont pourtant équivalentes pourvu qu’on soit d’accord sur la signification des mots « ordre » et « désordre ». Pour ne pas rentrer dans des débats subjectifs sans fin, les physiciens sont partis de l’idée que le désordre peut prendre mille et une formes différentes alors que l’ordre désigne en général un état assez bien défini: un Rubik’s Cube mélangé peut prendre des milliards d’aspects différents, mais la seule configuration « résolue » est celle dont toutes les faces ont la même couleur. Le « désordre » n’est donc pas un concept aussi précis que « l’ordre », de la même façon que les « non-éléphants » ne définissent pas une espèce animale aussi bien identifiée que les éléphants.

Avec cette définition le score moyen des dés peut être vu comme l’état le plus « désordonné », puisqu’il est compatible avec le plus grand nombre de combinaisons. L’entropie, définie au départ comme une mesure de notre ignorance, peut donc être vue comme la mesure d’un désordre. Et l’évolution vers l’état d’entropie maximale s’interprète comme une tendance spontanée au désordre. Ce principe statistique doit fasciner mes deux ados car ils tiennent à m’en démontrer quotidiennement la validité avec leur chambre. Ca marche à tous les coups!

Il y a mille et une façons variantes de désordre. (Source ici)

La formule magique de Boltzmann

Source: Tumblr

Pour mesurer l’entropie d’un état X, on aurait pu la définir directement comme le nombre de combinaisons Wx compatibles avec cet état X. Mais lorsqu’il travailla le concept sous cet angle statistique, Boltzmann préféra la mesurer proportionnellement à son logarithme:

S= k Log Wx.

Il était si fier de cette formule qu’il la fit graver sur sa tombe. Il faut dire que l’idée d’introduire ce logarithme est assez géniale. Il transforme les multiplications en additions et grâce à lui l’entropie devient une grandeur proportionnelle à la taille du système, comme le sont le volume ou l’énergie.

Par exemple, le nombre d’arrangements réalisables avec n dés vaut Wn=6n donc S est proportionnel à Log(Wn)= n Log(6). Autre propriété bien agréable: l’entropie s’additionne quand on mélange deux systèmes:

Pourquoi la nature a horreur du vide, pourquoi le temps s’écoule irréversiblement etc.

Pourquoi la nature a horreur du vide, pourquoi le temps s’écoule irréversiblement etc.

Avec cette formule on peut attaquer les problèmes les plus divers. Par exemple pourquoi un gaz occupe-t-il tout l’espace du récipient qui le contient? Encore un coup du deuxième principe, pardi! Divisez mentalement le volume du récipient en petites boîtes. A chaque instant, les molécules de gaz se répartissent aléatoirement dans ces boîtes et comme elles sont très nombreuses (environ 1022 par litre de gaz), elles se prêtent de bonne grâce au principe d’entropie maximale.

On vient de voir que l’entropie d’une configuration spatiale est proportionnelle au logarithme du nombre de combinaisons microscopiques compatibles avec cet état. Supposez que vous ayez à ranger 10 boules dans une, deux ou trois boîtes. Combien avez-vous de rangements possibles dans chaque cas?

Plus le nombre de boîtes occupé est grand, plus le nombre de combinaisons -et donc la quantité d’entropie- augmente. L’entropie est donc maximale lorsque toutes les unités de volumes disponibles sont occupées. Le deuxième principe prédit ainsi que le gaz ne laissera aucune unité de volume inoccupée.

Avec la formule de Boltzmann S ~ k Log W on peut calculer combien vaut exactement l’entropie d’un état du système (ici). Si on appelle pi la probabilité d’occupation de la boîte numéro i, on trouve:

S = – ∑pi Log(pi)

Il est alors possible de trouver la condition pour laquelle l’entropie est maximale: il faut que toutes les boîtes aient la même probabilité d’occupation. Le deuxième principe explique donc pourquoi une goutte d’encre tombée dans un verre d’eau diffuse jusqu’à ce que la concentration soit homogène partout. Ainsi la flèche du temps naît du deuxième principe…

L’entropie, comme mesure de l’inattendu

La formule ci-dessus est universelle (à une constante de proportionnalité près) et s’applique à n’importe quel système associé à des probabilités. Par exemple on peut calculer l’entropie de l’alphabet (associée à la probabilité de chaque lettre), d’une phrase ou d’un texte (avec la probabilité de chaque mot) etc. L’entropie mesure alors non pas la « quantité d’information », une notion hautement subjective, mais plutôt l’imprédictibilité du truc qu’on mesure:

- Pour l’alphabet, l’entropie mesure le degré d’équiprobabilité des lettres. Si l’entropie est faible, certaines lettres sont très rares et d’autres plus fréquentes. Elle indique donc qu’il est possible de tirer parti de la prédictibilité de certaines lettres pour comprimer efficacement le codage dans cette langue. Et aussi qu’il doit être amusant de jouer au scrabble dans cette langue.

- Pour l’entropie d’une phrase, il est encore plus dangereux de parler de quantité d’information au sens habituel. La phrase « Un Labrador est un chien » possède une entropie plus basse (donc contiendrait moins « d’information ») que « un Labrador est un eucaryote ». La phrase qui contient le plus d’information est faite de mots choisis au hasard! L’entropie renseigne là encore sur la difficulté à comprimer le codage de la phrase en question. Plus elle est élevée, plus la phrase est inattendue: l’entropie indique en quelque sorte le degré de surprise, d’originalité du message.

L’entropie mesure donc le degré d’imprévu d’un signal ou pour être précis, sa compressibilité maximale si on cherche à le coder. On comprend qu’elle ait intéressé les pionniers de l’informatique!

L’entropie et la température: on y arrive (enfin!)

Après cette longue digression, reprenons nos boîtes et imaginons qu’elles représentent non plus les unités de volume, mais les différents états d’énergie Ei que peuvent prendre des molécules de gaz. De la même façon que précédemment on peut chercher à quelle condition l’entropie est maximale, mais le calcul est cette fois légèrement différent car on doit tenir compte du fait que l’énergie totale est constante. Cette contrainte supplémentaire modifie l’équation de maximisation de l’entropie. La loi de probabilité que l’on obtient n’est plus celle de l’équiprobabilité des boîtes mais la statistique de Boltzmann:

pi exp(-βEi) (le calcul détaillé est ici).

Cette formule est un peu magique parce qu’elle relie la loi de probabilité des niveaux d’énergie, l’entropie et ce petit paramètre β qui comme on l’a vu dans le dernier billet est l’inverse de la température à une constante de proportionnalité près.

Encore un petit calcul et on trouve que : C’est cette formule qui définit aujourd’hui la température: c’est la quantité d’énergie nécessaire pour faire varier l’entropie d’une unité. Je vous laisse méditer ça jusqu’au prochain billet!

Sources et compléments:

J’ai concocté ce petit document qui explique en une page les principaux calculs.

Pour une démonstration complète de la statistique de Boltzmann, voir par exemple ce cours ou celui (en vidéo) de Leonard Susskind

L’exemple des dés m’a été inspiré par ce blog

Billets connexes:

Températures: de l’autre côté du miroir, le billet précédent

Bayes ou le vivant réduit au calcul, sur notre tendance irrépressible à baisser l’entropie!

22 comments for “Au fait c’est quoi l’entropie?”